DITOLAK pada perayapan Robot.txt Crawler Adsense memang menyakitkan. Karena otomatis pendapatan kita kemungkinan akan mengalami masalah di kemudian hari. Hal itu pernah saya alami pada web ini dimana ketika salah satu artikel saya terbitkan, langsung dari Team Adsense Google memberi sebuah peringatan lewat Kebijakan Adsense di Dashboard Adsense pada akun saya. Sungguh sebuah hal yang belum saya alami sebelumnya.

Sebelumnya ketika saya membuat sebuah artikel dan kemudian saya publish tidak mengalami masalah apapun. Baru kali ini mengalami masalah dan saya belum menemukan cara memecahkannya. Tapi bagaimanapun juga tetap akan saya perjuangkan karena ini adalah salah satu sumber penghasilan tambahan untuk saya. Otomatis penghasilan turunkah? belum tentu juga. Karena saya akan membagikan cerita ini kepada kalian dan seumpama mengalami hal yang sama bisa langsung memecahkan solusinya.

Baca Juga :

- Apakah Adsense itu dan Bagaimana Sejarah Berdirinya dan Kelebihannya

- 12 Cara Jitu Mendaftar Google Adsense Berdasar Pengalaman Pribadi

- Cara Membuat Sitemap Untuk Mempercepat Index Google Search Engine

- Mengatasi Penghasilan Anda Beresiko dengan Menambah File Ads.txt

- Mengatasi Item Kesalahan Pengalihan Pada Blog di Search Console

Pada artikel yang terdeteksi pemblokiran oleh Crawler Robots.txt itu adalah pada artikel https://www.alifacode.com/2022/09/7-cara-memasang-script-anti-copas-artikel-di-postingan-blog-html. Dalam peringatan tersebut tertulis dengan jelas bahwa "Crawler Adsense kami tidak dapat mengakses situs Anda. Masalah ini bukan Pelanggaran Kebijakan". Huh untunglah bukan karena kebijakan Adsense Google yang kena. Karena pembatasan iklan ini sangat mengganggu saya dan website yang saya kelola. Karena bila lambat laun ketika tidak ada tindakan, kemungkinan Google Adsense akan membanned akun saya.

Saya mencoba dengan cara :

Memperbaiki Masalah Adsense Ditolak Crawler Robots.txt

1. Saya menuju ke Setelan, kemudian2. Pilih Crawler dan Pengindeksan

3. Pilih lagi Aktifkan robots.txt kustom

4. Pilih lagi robots.txt kustom

Klik saja itu robots.txt kustom

Didalamnya ada tulisan seperti ini :

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.alifacode.com/sitemap.xml

Hapus yang :

User-agent: Googlebot

Disallow: /nogooglebot/

Jadinya nanti seperti ini :

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.alifacode.com/sitemap.xml

Kemudian masuk ke Artikel dan artikel yang terdeteksi itu langsung saja HAPUS

Tapi sebelumnya back up dulu artikelnya buat arsip di kemudian hari.

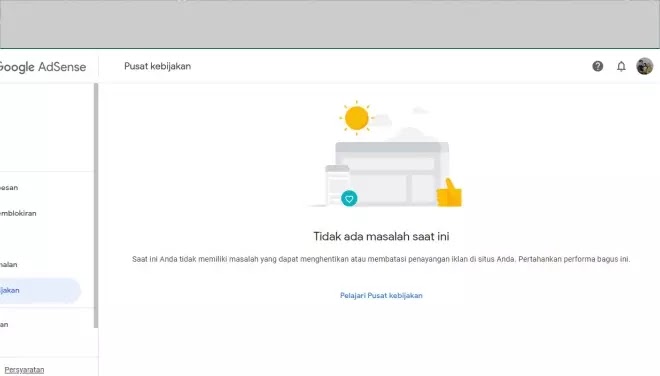

Setelah saya tunggu selama sekitar 1x24 jam. Peringatan itu pun hilang dan sekarang sudah normal kembali seperti ini :

Nah sudah jadi itu tutorialnya. Semoga kalian yang mengalami hal yang sama kayak saya bisa memperbaikinya. Soalnya nanti akan sangat bermasalah bila tidak segera diperbaiki. Selamat mencoba dan semoga berhasil. -- Seperti yang dikatakan Napoleon : "Kesederhanaan adalah dasar segala moral dan kebajikan utama manusia. Tanpa kesederhanaan, manusia tidak ada bedanya dengan binatang".